반응형

- 음란물 탐지 및 연령 그룹 분류 네트워크를 위한 두 가지 전략 사용

- 바이너리 CSA 분류를 위한 decision level fusion

- 의심 이미지 재배열을 위한 score level fusion

- decision/score level - 유사하나 융합 전 점수가 일치/비일치 결정으로 전환된다는 점이 다름( 출처: score/decision level fusion 관련 링크)

- AttM-CNN model

- 아키텍처

- 바이너리 CSA 분류를 위한 decision level fusion

- 의심 이미지 재배열을 위한 score level fusion

- decision/score level - 유사하나 융합 전 점수가 일치/비일치 결정으로 전환된다는 점이 다름( 출처: score/decision level fusion 관련 링크)

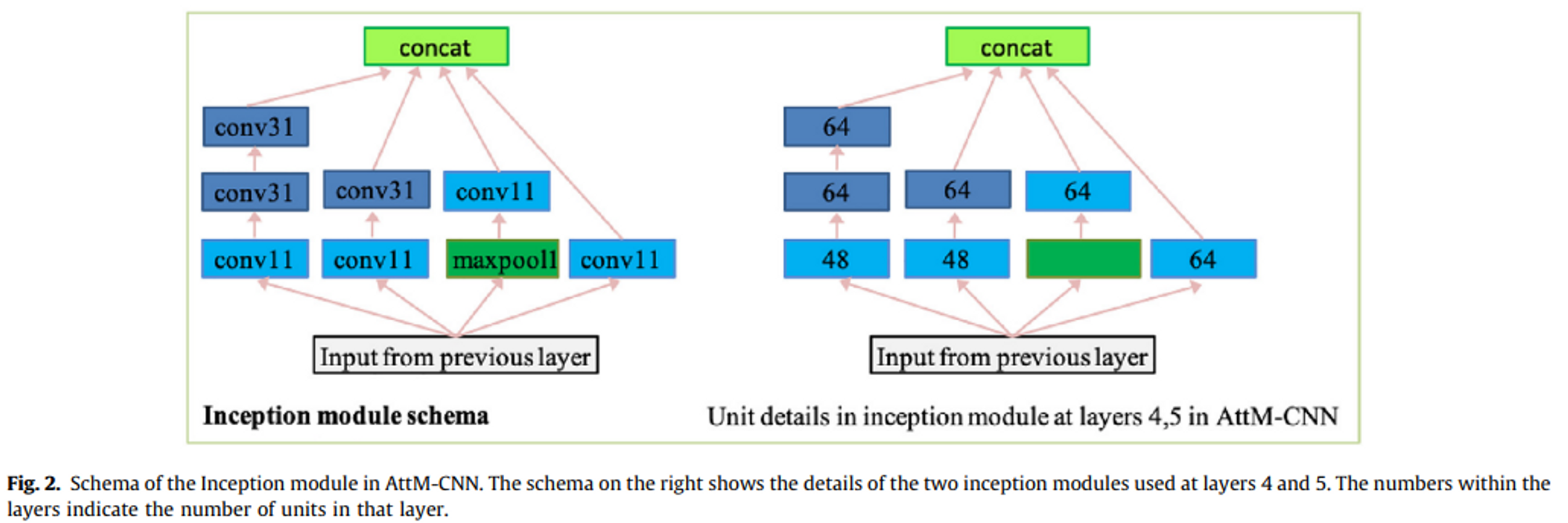

- 아키텍처

- convAB: AxA filter size, B의 stride의 layer

- maxpool■: ■x■ filter size, ■의 stride

- AttM-CNN 개요

- 제안 방법(아키텍처의 장점)

- 스포트라이트를 받을 가장 중요한 이미지 영역을 강화하기 위한 시각적 attention

- softmax와 중심 손실을 결합하여 보다 식별 가능한 표현을 학습하는 메트릭 학습

- 최근 딥 네트워크 아키텍처의 구성 요소, (Residual connection, Inception)의 계산 비용 매개변수의 수를 낮게 유지

- 흐름

- 1x1 convolutions: 네트워크 레이어 증가, 필터 차원 감소의 목적

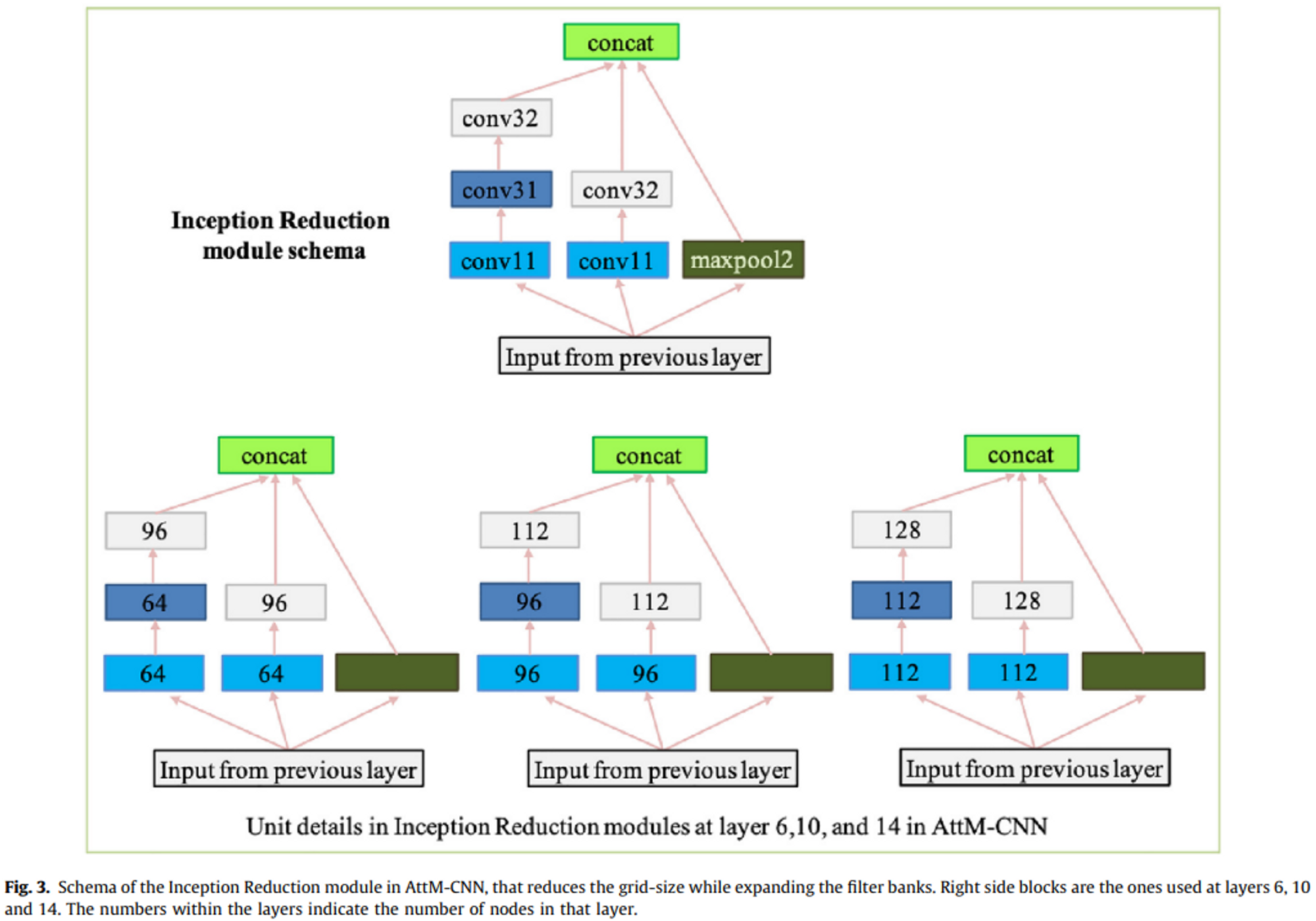

- Inception reduction blocks: 컨볼루션 수행, 피쳐맵 다운샘플링의 목적

- pooling layer → residual connection, additional 1x1 convolution

- first attention module(input: 32x32x384 feature map)

- Inception reduction layer, two Inception-ResNet layer

- 음란물 탐지 및 연령 그룹 분류 네트워크를 위한 두 가지 전략 사용

- AttM-CNN model

- 아키텍처

- convAB: AxA filter size, B의 stride의 layer

- maxpool■: ■x■ filter size, ■의 stride

- 제안 방법(아키텍처의 장점)

- 스포트라이트를 받을 가장 중요한 이미지 영역을 강화하기 위한 시각적 attention

- softmax와 중심 손실을 결합하여 보다 식별 가능한 표현을 학습하는 메트릭 학습

- 최근 딥 네트워크 아키텍처의 구성 요소, (Residual connection, Inception)의 계산 비용 매개변수의 수를 낮게 유지

- 흐름

- 1x1 convolutions: 네트워크 레이어 증가, 필터 차원 감소의 목적

- Inception reduction blocks: 컨볼루션 수행, 피쳐맵 다운샘플링의 목적

- pooling layer → residual connection, additional 1x1 convolution

- first attention module(input: 32x32x384 feature map)

- Inception reduction layer, two Inception-ResNet layer

- 아키텍처

- 제안 방법(아키텍처의 장점)

반응형

댓글